Pourquoi l'avenir de votre entreprise se joue aujourd'hui (et comment le sécuriser).

1. Introduction : Du durcissement système de 2004 à la gouvernance de l'agence en 2025

En 2004, Cédric Chatelain publiait ses bonnes pratiques de sécurité : l'époque était aux vers, au spam et aux intrusions rudimentaires. La défense consistait alors à "fermer les services Windows inutiles" pour réduire la surface d'attaque de systèmes statiques. Vingt ans plus tard, le paradigme a radicalement muté. Nous ne sécurisons plus simplement des ports ou des services ; nous devons désormais gouverner l'agence des modèles et l'intention de systèmes capables de diviser des tâches de manière autonome.

Si les outils ont changé, la nécessité d'une attitude proactive reste le seul fil conducteur de votre survie numérique. En 2025, l'IA générative n'est plus un gadget, c'est un moteur de croissance qui, sans une gouvernance de fer, peut transformer une erreur de prompt en un incident systémique. Passer du mode "réactif" au mode "excellence" n'est plus une option technique, c'est un impératif de souveraineté pour votre direction.

2. Le ROI de la confiance : Transformer la sécurité en accélérateur de business

Ne voyez plus la sécurité comme un centre de coûts, mais comme un levier de rentabilité premium. Les entreprises qui intègrent la gouvernance de l'IA dès la phase de design captent une valeur économique directe.

- ROI de 600 % sur 3 ans : Pour un investissement maîtrisé (env. 1 200 €/mois pour une PME), le retour sur investissement est massif grâce à la fiabilisation des processus.

- Réduction de 40 % des primes d'assurance cyber : Un profil de risque "renforcé" et auditable permet de négocier drastiquement vos contrats d'assurance.

- Augmentation de 30 % du taux de conversion client : La confiance est devenue un argument de vente. Vos clients choisiront l'IA qu'ils savent sécurisée et éthique.

Le coût de l'inaction : À l'inverse, le coût moyen d'une fuite de données pour une PME est aujourd'hui estimé à 100 000 €. Ignorer la sécurité de l'IA, c'est accepter une épée de Damoclès financière sur votre bilan.

3. L'AI Security Officer (AISO) : Votre feuille de route sur 12 mois

Pour piloter cette transformation, la nomination d'un AI Security Officer (AISO) est cruciale. Ce rôle ne se limite pas à la technique ; il assure l'alignement entre vos objectifs métier et la sécurité des modèles.

« La nomination d'un responsable dédié est cruciale pour superviser la sécurité et l'alignement stratégique. »

Voici le workflow pragmatique que votre AISO doit déployer pour passer de la réaction à l'excellence :

- Phase 1 : Fondations (0-3 mois) : Inventaire des actifs IA, évaluation des risques initiale et définition des politiques de base.

- Phase 2 : Protection (3-6 mois) : Mise en place des contrôles d'accès, monitoring actif des modèles et procédures d'incident spécifiques.

- Phase 3 : Excellence (6-12 mois) : Adoption du MLSecOps, tests de Red Teaming automatisés et pleine conformité réglementaire.

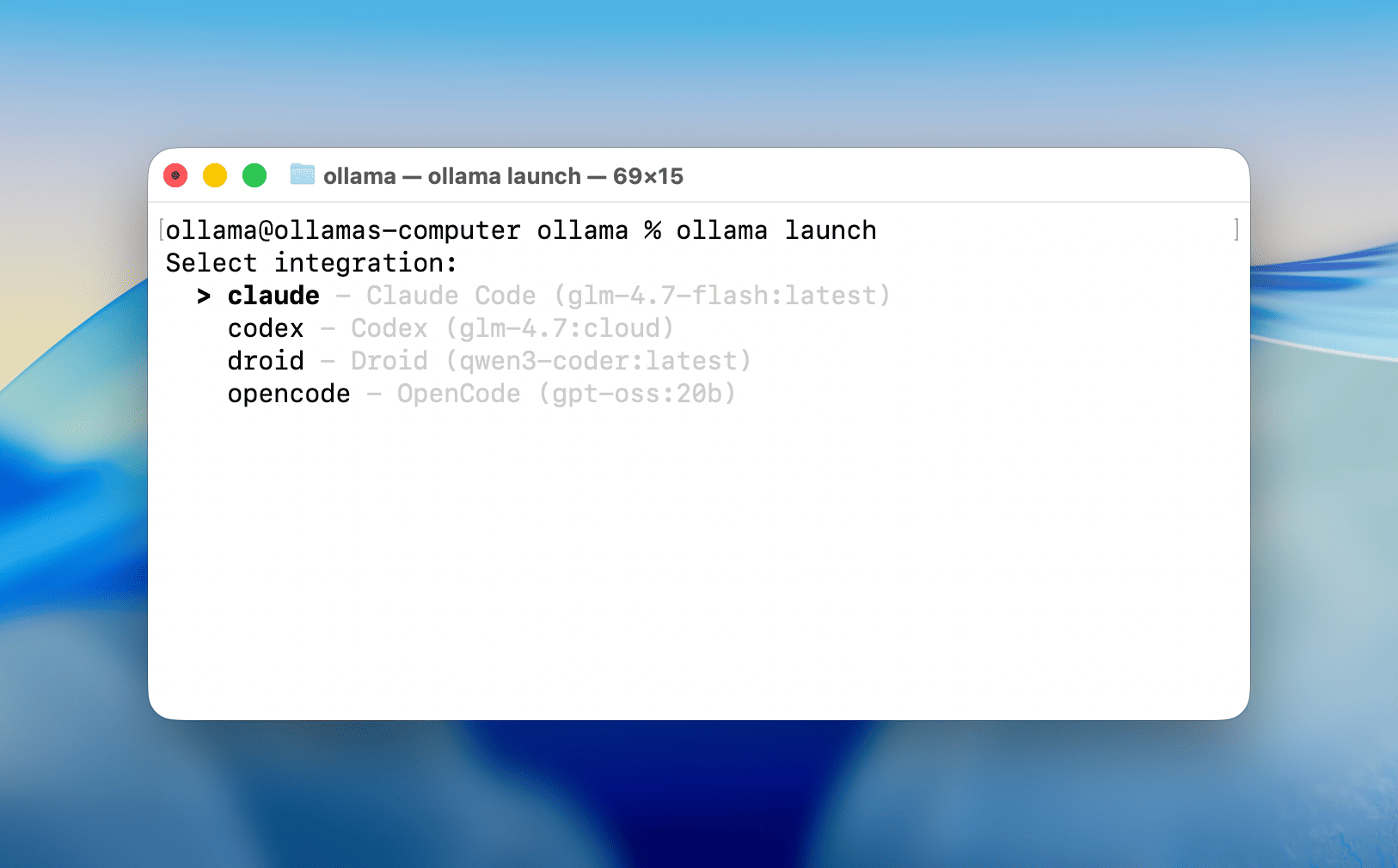

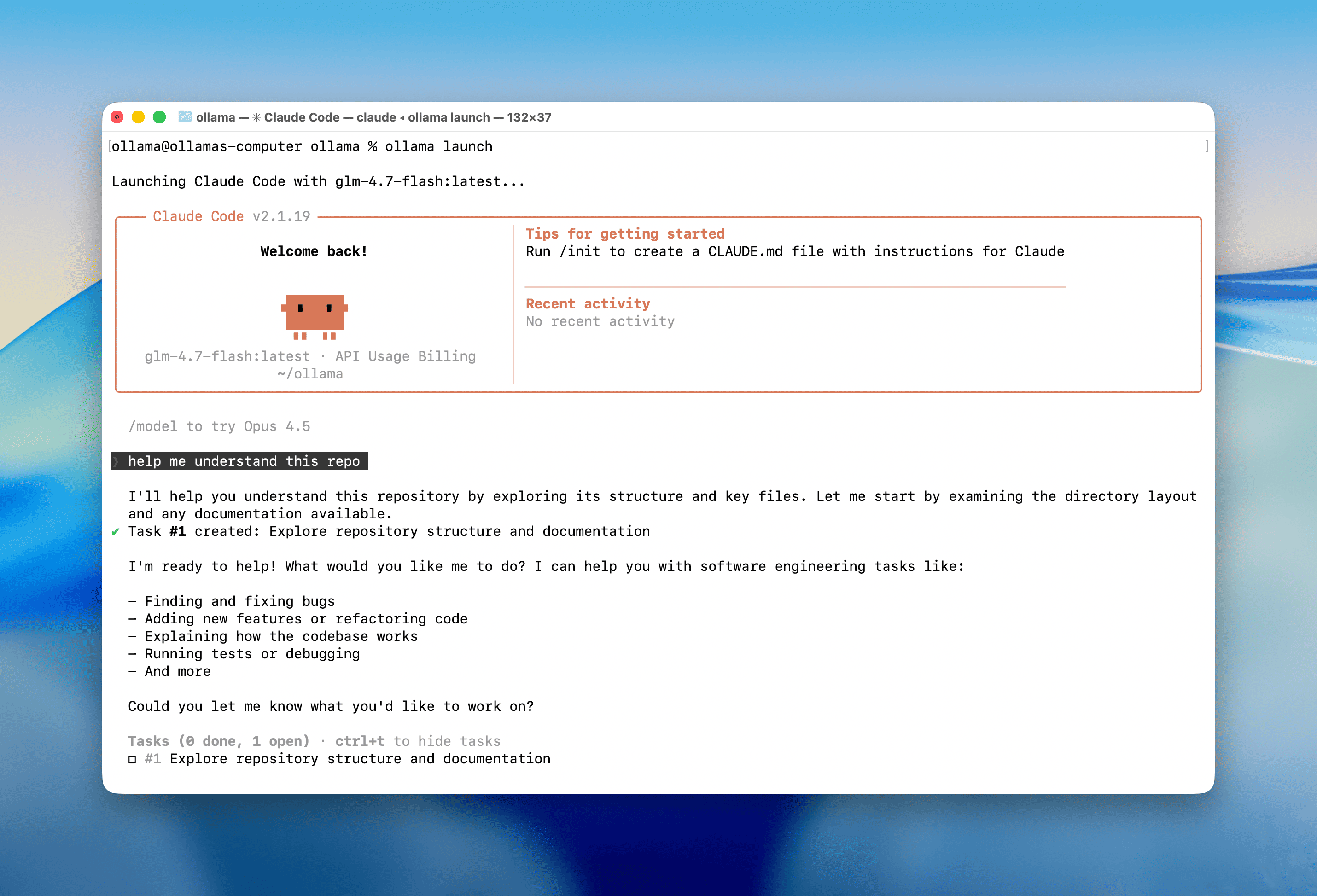

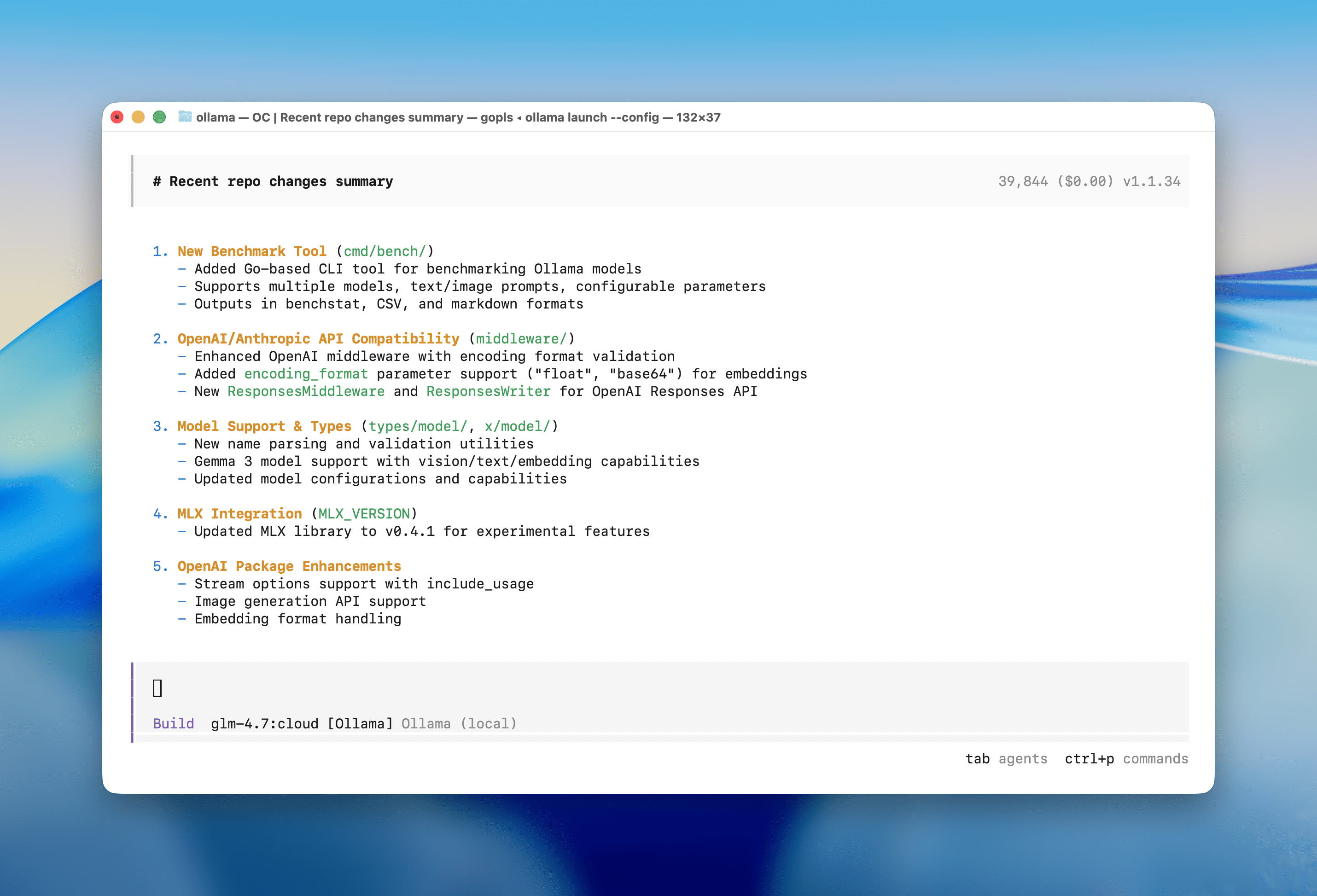

4. Souveraineté et Zero Trust : Le combo Ollama + Mistral sur PC-NPU

Le "Cloud à tout prix" montre ses limites face aux enjeux de confidentialité. L'émergence d'architectures locales, utilisant Ollama et Mistral sur des PC équipés de NPU (Neural Processing Units), permet de traiter vos données les plus sensibles sans qu'elles ne quittent jamais votre périmètre physique.

Cette approche permet d'implémenter une véritable architecture Zero Trust adaptée à l'IA. En isolant les contextes par session client et en évitant les fuites vers des LLM tiers, vous garantissez une isolation totale. Pour une entreprise soucieuse de ses secrets industriels, l'innovation locale n'est pas un retour en arrière, c'est le rempart ultime pour une souveraineté technologique totale.

5. Au-delà du bug : La manipulation de l'agence et le risque "Chaos-GPT"

Les menaces modernes ne visent pas seulement votre code, elles ciblent l'intention du modèle.

- L'Injection de Prompt : Détourner les instructions pour forcer l'IA à révéler des données ou à ignorer ses garde-fous.

- L'Empoisonnement de Données : Corrompre silencieusement les jeux d'entraînement pour fausser les décisions futures.

- Chaos-GPT et l'Agence Autonome : Le véritable danger réside dans l'agence (la capacité d'action). Des outils comme Chaos-GPT illustrent comment une IA peut diviser un but malveillant en sous-tâches autonomes sur Internet. Le risque n'est plus un "plantage" informatique, mais une accélération massive de la malveillance humaine par l'autonomie de la machine.

6. Responsabilité et auditabilité : Distinguer l'accident de l'acte intentionnel

Selon le cadre MITRE, l'IA n'a pas de but propre mais amplifie l'intention de l'utilisateur. Pour protéger votre entreprise, l'auditabilité est le maître-mot. Vous devez être capable de tracer chaque décision pour distinguer un "accident d'IA" (comportement imprévu du modèle) d'un "acte intentionnel" (utilisation malveillante par un humain).

Pour ce faire, le déploiement de "Assurance Cases" (dossiers d'assurance) est indispensable. Ce sont des corps de preuves documentés démontrant, avant tout déploiement, que le système satisfait aux propriétés de sécurité critiques. Sans cette traçabilité, la responsabilité légale de votre entreprise devient indéfendable.

7. La règle d'or de la résilience : 3-2-1 et RTO < 4h

La prévention est nécessaire, mais la résilience est vitale. Votre Plan de Reprise d'Activité Numérique (PRAN) doit être calibré pour l'ère de l'IA.

Métrique | Objectif de Résilience Stratégique |

Stratégie 3-2-1 | 3 copies, 2 supports, 1 copie hors site géorépliquée |

RTO (Délai de reprise) | < 4 heures |

RPO (Perte de données) | < 15 minutes |

Validation | Tests mensuels de restauration & DR Drills trimestriels |

8. Feuille de route pour 2025 : De la réaction à l'excellence

L'année 2025 marque un tournant réglementaire majeur. Avec l'entrée en vigueur de l'EU AI Act, les entreprises négligentes risquent des pénalités atteignant 4 % de leur chiffre d'affaires mondial.

Aujourd'hui, la plupart des organisations affichent un score de maturité "Réactif" (environ 37/100 dans nos audits). Votre objectif doit être d'atteindre le niveau "Excellence" (100/100) en suivant les cadres du NIST AI RMF (Gouverner, Cartographier, Mesurer, Gérer).

Dernière réflexion pour votre prochain comité de direction : Êtes-vous un leader "réactif" subissant la menace, ou êtes-vous prêt à transformer l'IA en votre meilleur bouclier stratégique ? L'IA est soit votre plus grand risque, soit votre plus grand avantage concurrentiel. À vous de choisir quel dossier présenter à vos actionnaires en 2026.

Top Cybersecurity Software of 2026 - TechnologyAdvice

Cette partie détaille les enjeux, les bénéfices économiques, les cadres contractuels et les mesures techniques de l'assurance liés à l'intelligence artificielle, en mettant l'accent sur la continuité d'activité (PRAN).

1. Définition et Cadre de l'Assurance de l'IA

L'assurance de l'IA est un processus de cycle de vie visant à fournir une confiance justifiée dans la capacité d'un système à fonctionner efficacement tout en maintenant les risques à des niveaux acceptables. Elle englobe la sécurité, l'équité, la fiabilité, la robustesse, la confidentialité et la gouvernabilité.

2. Démarches et Contrats : L'Excellence comme Levier

Pour obtenir une couverture optimale et négocier les conditions contractuelles, les organisations doivent passer d'un profil "réactif" à un profil "résilient".

- Réduction des primes : Un profil de sécurité IA renforcé permet d'obtenir une réduction estimée à 40 % sur les primes d'assurance cyber.

- Dossiers d'Assurance (Assurance Cases) : Il est recommandé de développer des dossiers documentant la preuve que le système satisfait aux propriétés de sécurité critiques avant son déploiement.

- Auditabilité et Transparence : Les contrats exigent souvent une auditabilité permettant de tracer l'intention humaine et l'exécution des décisions par l'IA afin d'établir les responsabilités en cas de dommage. L'usage de "model cards" est préconisé pour définir les limites d'utilisation du système.

- Conformité Réglementaire : La préparation à l'EU AI Act 2025 est cruciale pour éviter des pénalités pouvant atteindre 4 % du chiffre d'affaires, risques que les assureurs cherchent à minimiser.

3. Risques Identifiés et Couvertures

L'assurance doit couvrir plusieurs types de vulnérabilités spécifiques à l'IA :

- Menaces techniques : Injections de prompts (prompt injection), vol de modèle (model stealing), empoisonnement de données (data poisoning) et attaques adversariales.

- Failles opérationnelles : Hallucinations malveillantes, dérives de modèles (drift) et erreurs de configuration.

- Risques socio-techniques : Biais discriminatoires et atteintes à la confidentialité des données.

- Impact financier : Le coût moyen d'une faille de données pour une PME est estimé à 100 000 € ; une bonne assurance technique permet de prévenir ces coûts.

4. Le PRAN (Plan de Reprise d'Activité Numérique)

Une assurance complète nécessite la garantie de la continuité des services d'IA via un PRAN (ou PRA) rigoureux.

- Stratégie de Sauvegarde 3-2-1 : Maintenir 3 copies des données sur 2 supports différents (ex: SharePoint et Azure) avec 1 copie géorépliquée hors site.

- Objectifs de Rétablissement (SLA) :

- RTO (Recovery Time Objective) : Délai de reprise inférieur à 4 heures.

- RPO (Recovery Point Objective) : Perte de données maximale autorisée inférieure à 15 minutes (grâce à une synchronisation en temps réel pour les données critiques).

- Fréquences de sauvegarde : Synchronisation continue pour les données clients, bi-quotidienne pour les configurations d'agents IA et quotidienne pour les workflows.

- Validation de la résilience : Pour prouver la fiabilité aux assureurs, il est impératif de réaliser des tests de restauration mensuels et des exercices de basculement complet (DR Drill) trimestriels.

5. Rentabilité de l'Investissement (ROI)

La mise en place d'une telle gouvernance et d'une architecture résiliente présente un ROI estimé à 600 % sur 3 ans. Au-delà de la sécurité, cela améliore le taux de conversion client de 30 % grâce à un positionnement sécuritaire "premium".

Rapport de Résilience Numérique spécifiquement conçu pour votre assureur.

Ce document officiel regroupe tous les justificatifs techniques et opérationnels pour valider votre passage à un profil de risque "Résilient". Voici les points clés inclus dans le rapport :

- Stratégie de Protection 3-2-1 : Détail de l'architecture multi-couches utilisant SharePoint et Azure avec géoréplication hors site.

- Métriques de Continuité (SLA) : Justification de vos objectifs de rétablissement ambitieux, soit un RTO < 4h et un RPO < 15 min grâce à la synchronisation en temps réel des données clients.

- Registre de Validation : Preuves des tests d'intégrité mensuels et des exercices de basculement (DR Drills) trimestriels.

- Gouvernance : Confirmation de la supervision directe par l'AI Security Officer (AISO).

- Impact Financier : Argumentaire pour obtenir la réduction de 40 % sur vos primes d'assurance cyber identifiée dans votre stratégie de ROI.

Consulter ce rapport :

Rapport de Résilience Numérique : Justification du Profil de Risque

Ce rapport technique détaille les fondements de notre stratégie de résilience numérique et de gouvernance des risques. Il a pour objectif de justifier formellement le classement du profil de risque de l'organisation auprès des souscripteurs d'assurance cyber, en démontrant l'alignement entre les mesures de protection des systèmes d'Intelligence Artificielle (IA) et les standards d'excellence du marché.

1. Objectifs de la Stratégie de Sauvegarde et Résilience des Données

La pérennité du patrimoine numérique repose sur une application rigoureuse de la stratégie de sauvegarde 3-2-1. Cette approche ne se limite pas aux données conventionnelles, mais englobe l'intégralité du cycle de vie des systèmes d'IA, incluant les poids des modèles (model weights), les datasets d'entraînement et le code de pipeline ML. L'intégrité est renforcée par l'utilisation de solutions locales (type Ollama et Mistral sur PC-NPU), garantissant une confidentialité maximale et une réduction drastique de la surface d'exposition liée aux flux externes.

- 3 copies des données : Maintien de trois instances distinctes pour chaque actif critique (poids des modèles, datasets sensibles et configurations de pipeline).

- 2 supports différents : Utilisation de technologies de stockage hétérogènes pour neutraliser les risques de défaillance matérielle systémique.

- 1 copie géorépliquée : Externalisation d'une version des données sur un site distant, assurant la reprise d'activité même en cas de sinistre majeur sur l'infrastructure principale.

2. Métriques Clés de Continuité d'Activité (PRAN)

Le Plan de Reprise d'Activité Numérique (PRAN) est dimensionné pour satisfaire aux exigences de "l'Assurance de l'IA", définie comme un processus de cycle de vie offrant une confiance justifiée dans la fiabilité et la robustesse du système.

Métrique | Objectif de Rétablissement | Justification Technique (Assurance de l'IA) |

RTO (Recovery Time Objective) | < 4 heures | Garantit une confiance justifiée dans la robustesse et la gouvernabilité du cycle de vie via un redéploiement automatisé des environnements IA. |

RPO (Recovery Point Objective) | < 15 minutes | Architecture de micro-sauvegardes à haute fréquence assurant la persistance de l'apprentissage et des données transactionnelles. |

Données clients | Synchronisation temps réel | Flux audités et tracés permettant une auditabilité complète et une traçabilité des décisions IA après restauration. |

3. Gouvernance de l'IA et Supervision de la Sécurité

La gouvernance organisationnelle s'appuie sur la nomination d'un AI Security Officer (AISO), pivot de la stratégie "Safety-First". Cette fonction opérationnalise le framework NIST AI RMF 1.0 pour transformer la conformité réactive en excellence sécuritaire.

L'AISO supervise la résilience via les quatre piliers du NIST :

- Gouverner : Instauration de politiques spécifiques à l'IA et intégration de la sécurité ML dans le comité de direction.

- Cartographier : Inventaire exhaustif des actifs IA et identification des vecteurs d'attaque (injection de prompts, vol de modèle, empoisonnement de données).

- Mesurer : Évaluation continue de la robustesse, incluant l'analyse du drift (dérive) des modèles et des tests de robustesse adversariale.

- Gérer : Déploiement d'une architecture Zero Trust et isolation des contextes par session client pour prévenir les fuites de données sensibles.

GOUVERNANCES. https://gouver2020.blogspot.com/

4. Registre de Validation Technique et Tests de Résilience

La validation de la maturité technologique repose sur un protocole de tests intensifs. Chaque exercice contribue à la constitution d'un Dossier d'Assurance (Assurance Case), corps de preuves documentées attestant que le système satisfait aux propriétés de sécurité critiques avant et pendant l'exploitation.

Type d'exercice | Fréquence | Objectif de validation | Résultat Documentaire |

Tests de restauration | Mensuels | Intégrité des poids des modèles et des datasets de secours. | Rapport de conformité technique |

DR Drills (PRAN) | Trimestriels | Simulation de panne totale et basculement sur site géorépliqué. | Preuve de résilience opérationnelle |

Automated Red Teaming | Continu | Identification de vulnérabilités (ex: model poisoning) via Arsenal/CALDERA. | Dossier d'Assurance (Assurance Case) |

5. Évaluation du Profil de Risque et Bénéfices Financiers

L'investissement structurel dans la sécurité IA est corrélé à une réduction significative de l'exposition financière. Pour une PME type, l'effort consenti permet de transformer le risque en avantage concurrentiel mesurable.

Key Takeaways : Impact Économique et ROI

- Baseline d'investissement : Un budget maîtrisé de 1 200 € / mois pour les contrôles et la gouvernance IA.

- Réduction des primes : Baisse de 40 % sur les primes d'assurance cyber grâce à un profil de risque classé "Renforcé".

- ROI estimé : Un retour sur investissement de 600 % sur 3 ans.

- Coûts évités : Protection contre les sinistres de données, dont le coût moyen est de 100 000 € par incident pour une PME.

6. Conformité Réglementaire et Standards d'Excellence

Le profil "Résilient" est validé par l'adhésion aux cadres légaux et normatifs les plus exigeants, avec un niveau de maturité globale classé "Défensif" en transition vers "l'Excellence".

- [x] EU AI Act 2025 : Préparation avancée (maturité estimée à 75 %) pour éviter les pénalités de 4 % du CA.

- [x] NIST AI RMF 1.0 : Intégration complète des fonctions de gestion des risques dans les pipelines MLSecOps.

- [x] Certification ISO 27001 : Cible prioritaire d'excellence pour la validation des processus de sécurité de l'information.

- [x] RGPD / LPD Suisse : Conformité renforcée avec anonymisation systématique et respect strict des droits des personnes.

7. Conclusion Technique

Le profil de risque de l'organisation est formellement classé comme "Résilient".

L'alignement structurel entre les mesures techniques de pointe — notamment la stratégie de sauvegarde 3-2-1 appliquée aux actifs IA et un PRAN garantissant un RTO < 4h — et une gouvernance pilotée par un AI Security Officer permet de confirmer une maîtrise complète des risques.

La production systématique de Dossiers d'Assurance (Assurance Cases) et le respect anticipé de l'EU AI Act offrent aux souscripteurs une garantie de stabilité et de robustesse face aux menaces numériques émergentes, tout en optimisant la performance financière du programme d'assurance.

Voici la liste des sources actualisées et des URL mentionnées dans les documents fournis, classées par thématique pour faciliter votre navigation :

1. Frameworks de Gouvernance et Standards Internationaux

- NIST AI Risk Management Framework (AI RMF 1.0) : Le cadre de référence pour la gestion des risques de l'IA est disponible à l'adresse https://doi.org/10.6028/NIST.AI.100-1.

- MITRE ATLAS (Adversarial Threat Landscape for AI Systems) : Ce référentiel documente les tactiques et techniques des adversaires ciblant les systèmes d'IA : https://atlas.mitre.org/.

- Model Cards : Documentation sur les fiches de transparence pour les modèles d'IA : https://huggingface.co/blog/model-cards.

- Politique de l'IA (Future of Life Institute) : Recommandations sur les politiques de sécurité : https://futureoflife.org/wp-content/uploads/2023/04/FLI_Policymaking_In_The_Pause.pdf.

2. Plateformes de Protection et Outils Techniques

- Brandefense : Solution de protection des risques numériques et de threat intelligence : https://brandefense.io.

- CALDERA : Framework d'automatisation des évaluations de cybersécurité : https://caldera.mitre.org/.

- Instance Dify VBCH : Interface de chat IA sécurisée (contexte suisse) : https://dify.vbch.ch/chat/.

- Support Microsoft : Assistance technique officielle : https://support.microsoft.com/en-us.

3. Rapports de Menaces et Statistiques (Analyse Perplexity)

Les sources suivantes ont été utilisées pour l'analyse des incidents en Europe :

- Tendances IoT : https://www.solutions-numeriques.com/iot-leurope-la-plus-touchee-depuis-le-debut-de-lannee/.

- CERT-FR (ANSSI) : Rapport sur l'état de la menace : https://www.cert.ssi.gouv.fr/uploads/CERTFR-2025-CTI-003.pdf.

- Orange Cyberdefense (Security Navigator 2025) : https://newsroom.orange.com/securitynavigator2025/.

- Cyber-assurance (Marsh) : Rapport sur les réclamations cyber 2024 : https://www.marsh.com/fr/services/cyber-risk/insights/cyber-claims-report-2024.html.

- Kaspersky Cybermap : Statistiques des attaques en temps réel : https://cybermap.kaspersky.com/fr/stats.

4. Bonnes Pratiques de Sécurité Informatique

- Vérification de Hoax : https://www.hoaxbuster.com/.

- Lutte contre le Spam (Spamhaus) : https://www.spamhaus.org/.

- Pare-feu et VPN :

- ZoneAlarm : https://www.zonealarm.com/.

- Comodo Firewall : https://personalfirewall.comodo.com/.

- Firetrust (VPN) : https://www.firetrust.com/products/hideaway-secure-unlimited-vpn.

5. Ressources Communautaires et Veille IA (U.G.A.I.A.)

Sites maintenus par le Groupe d'Utilisateurs IA d'Andorre pour la gouvernance et la méthodologie :

- Portail UGAIA : http://www.ugaia.eu.

- Le Cercle Guild4AI : https://lecercle.guild4ai.ai/.

- Blog de veille technologique : https://and500.blogspot.com/ et https://uga-ia.blogspot.com/.

- Site personnel d'Erol Giraudy : https://www.erolgiraudy.eu/.

Ces sources constituent la base documentaire pour l'élaboration de vos plans de résilience et de gouvernance de l'IA.

Mon dernier livre :

LA DICTATURE DE L’IA ET SA GOUVERNANCE. :Reprendre le contrôle : Guide pratique pour une souveraineté numérique européennede Pierre GIRAUDYCertains de mes autres livres:

Pour en savoir plus sur moi, mes blogs :

https://www.ugaia.eu/ https://larselesrse.blogspot.com/

https://gouver2020.blogspot.com/

https://cluboffice2010.blogspot.com

Sur YouTube :

https://www.youtube.com/@EROLGIRAUDY

Mes 15 livres :

https://www.ugaia.eu/p/mes-livres.html

Dans| le Catalogue général de la BnF :

Recherche simple "Giraudy Erol" : liste de notices | BnF Catalogue général

Users Group Artificial Intelligence Agentique (U.G.A.I.A.) mon blog :

Mes réseaux sociaux :

L' AI pour la Généalogie de UGAIA

L’intelligence artificielle des service pour les généalogistes :

P. Erol GIRAUDY

.png)

.png)

.png)