Lancement d’Ollama ollama launch

23 janvier 2026

Comprendre Ollama et OpenCode :

Étapes pour lancer un projet

Considérations

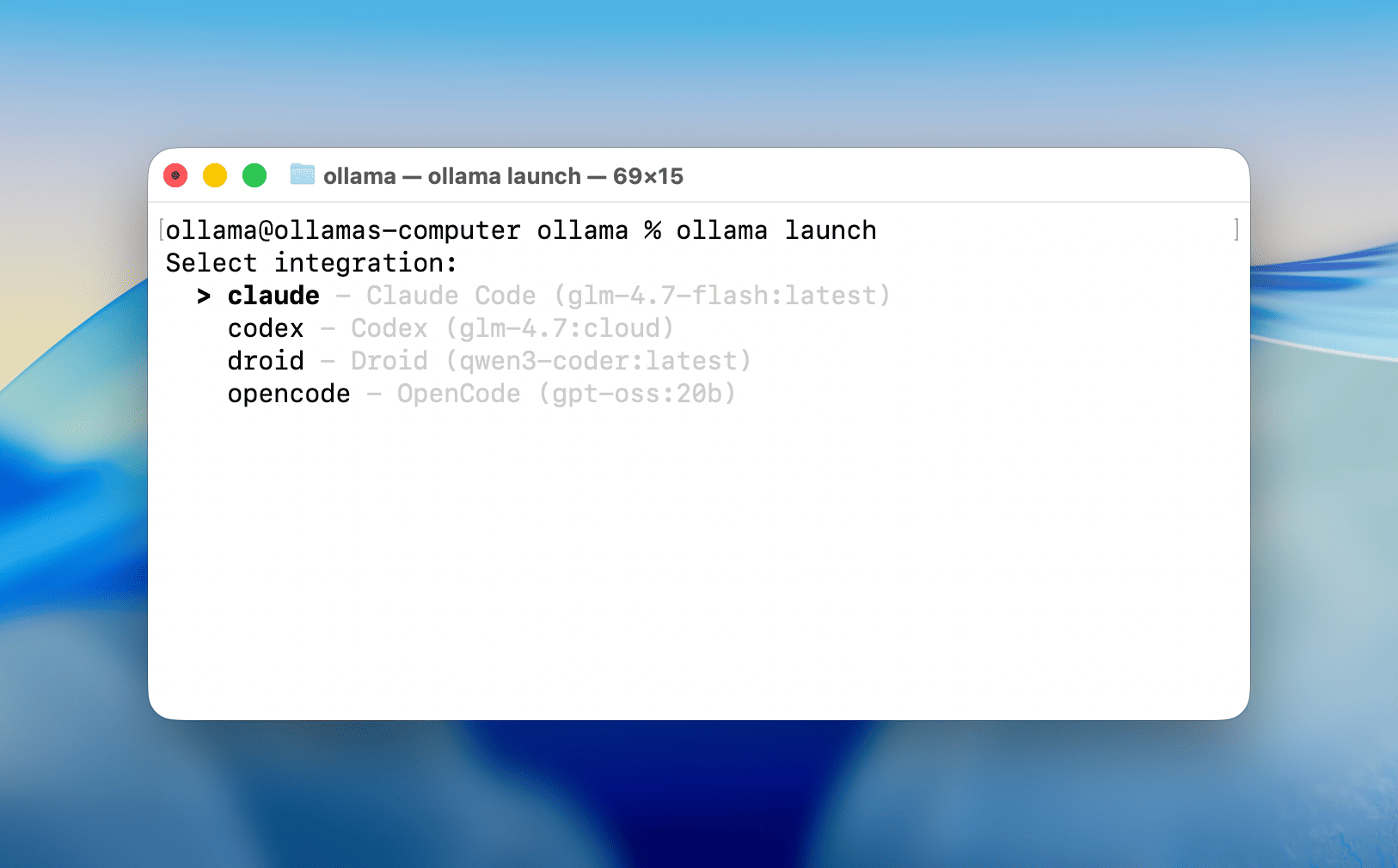

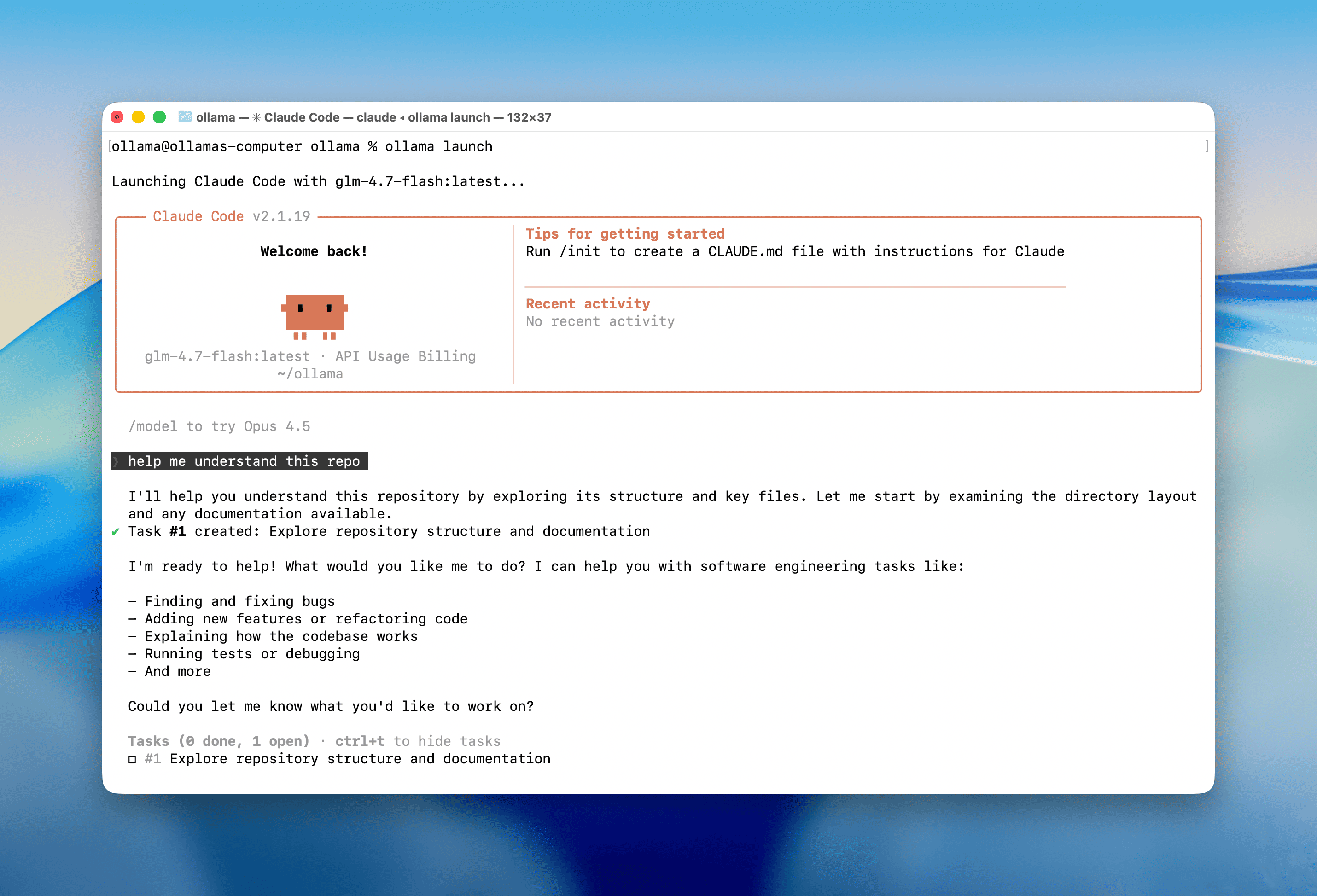

ollama launch est une nouvelle commande qui configure et exécute vos outils de codage préférés comme Claude Code, OpenCode et Codex avec des modèles locaux ou cloud. Aucune variable d’environnement ni fichier de configuration n’est nécessaire.

Commencez

Téléchargez Ollama v0.15+, puis ouvrez un terminal et exécutez :

# ~23 GB VRAM required with 64000 tokens context length

ollama pull glm-4.7-flash

# or use a cloud model (with full context length)

ollama pull glm-4.7:cloud

Configuration d’une commande

Code Claude :

ollama launch claude

OpenCode :

ollama launch opencode

This will guide you to select models and launch your chosen integration. No environment variables or config files needed.

Supported integrations

- Claude Code

- OpenCode

- Codex

- Droid

Recommended models for coding

Note: Coding tools work best with a full context length. Update the context length in Ollama’s settings to at least 64000 tokens. See the context length documentation on how to make changes.

Local models:

glm-4.7-flashqwen3-codergpt-oss:20b

Cloud models:

glm-4.7:cloudminimax-m2.1:cloudgpt-oss:120b-cloudqwen3-coder:480b-cloud

Extended coding sessions

If you have trouble running these models locally, Ollama also offers a cloud service with hosted models that has full context length and generous limits even at the free tier.

With this update Ollama now offers more usage and an extended 5-hour coding session window. See ollama.com/pricing for details.

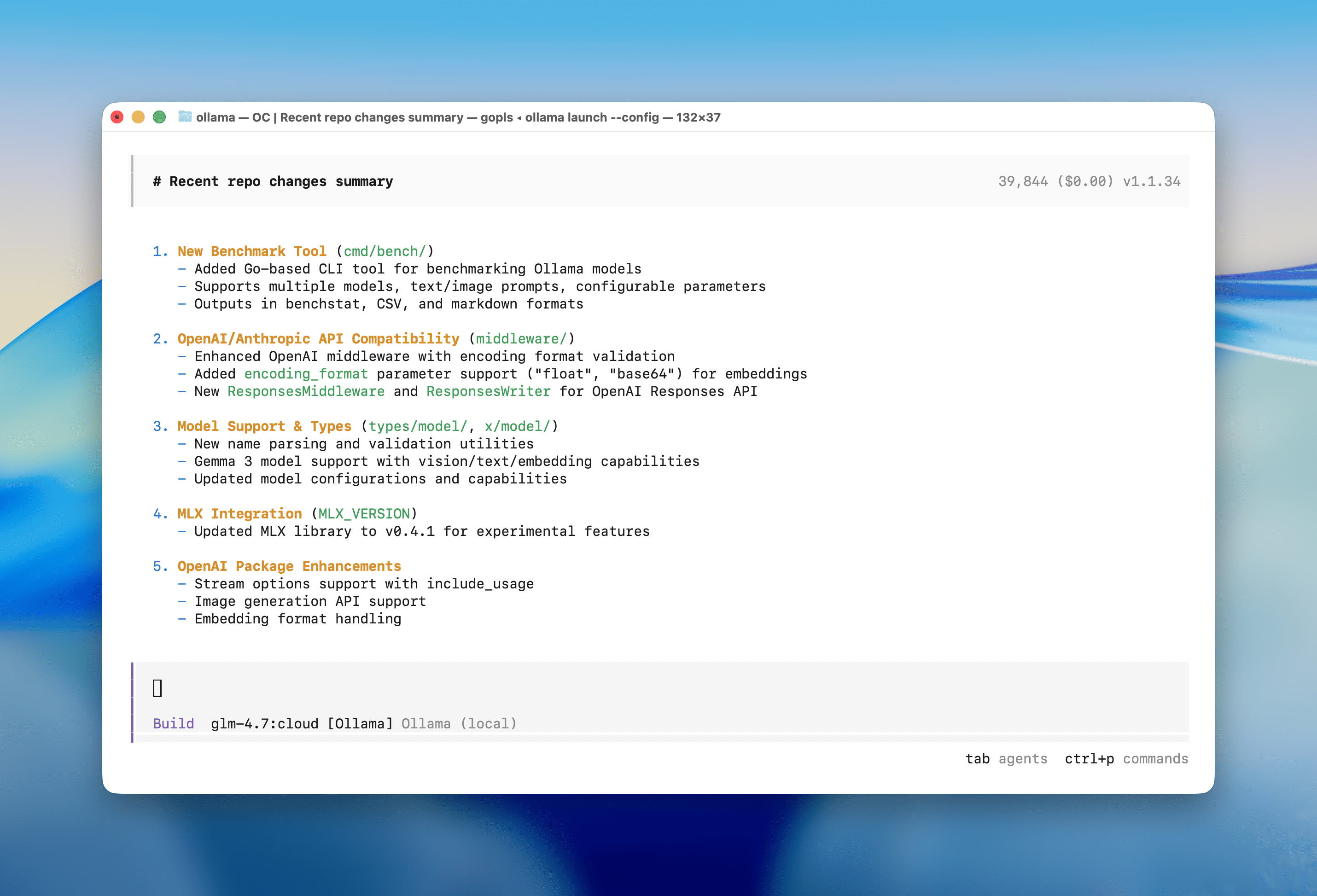

Configure only

To configure a tool without launching it immediately:

ollama launch opencode --configollama/ollama: Get up and running with OpenAI GLM-4.7, DeepSeek, gpt-oss, Qwen, Gemma and other models.https://github.com/ollama/ollama/blob/main/README.mdhttps://github.com/ollama

Context length - Ollama https://docs.ollama.com/context-length

Pas possible avec PHI4

Mieux avec Mistral

Le service est :

■ We're currently experiencing high demand, which may cause temporary errors.

Aucun commentaire:

Enregistrer un commentaire

Merci pour ce commentaire