Un prompt avec des balises pour la G·IA.

Pourquoi ce prompt, simplement je le fais fonctionner sur Ollama et PHI4 sans accès au Web.

Et cela fonctionne.

LLM-SHAREPOINT-TEAMS-O365-COPILOT

Pourquoi ce prompt, simplement je le fais fonctionner sur Ollama et PHI4 sans accès au Web.

Et cela fonctionne.

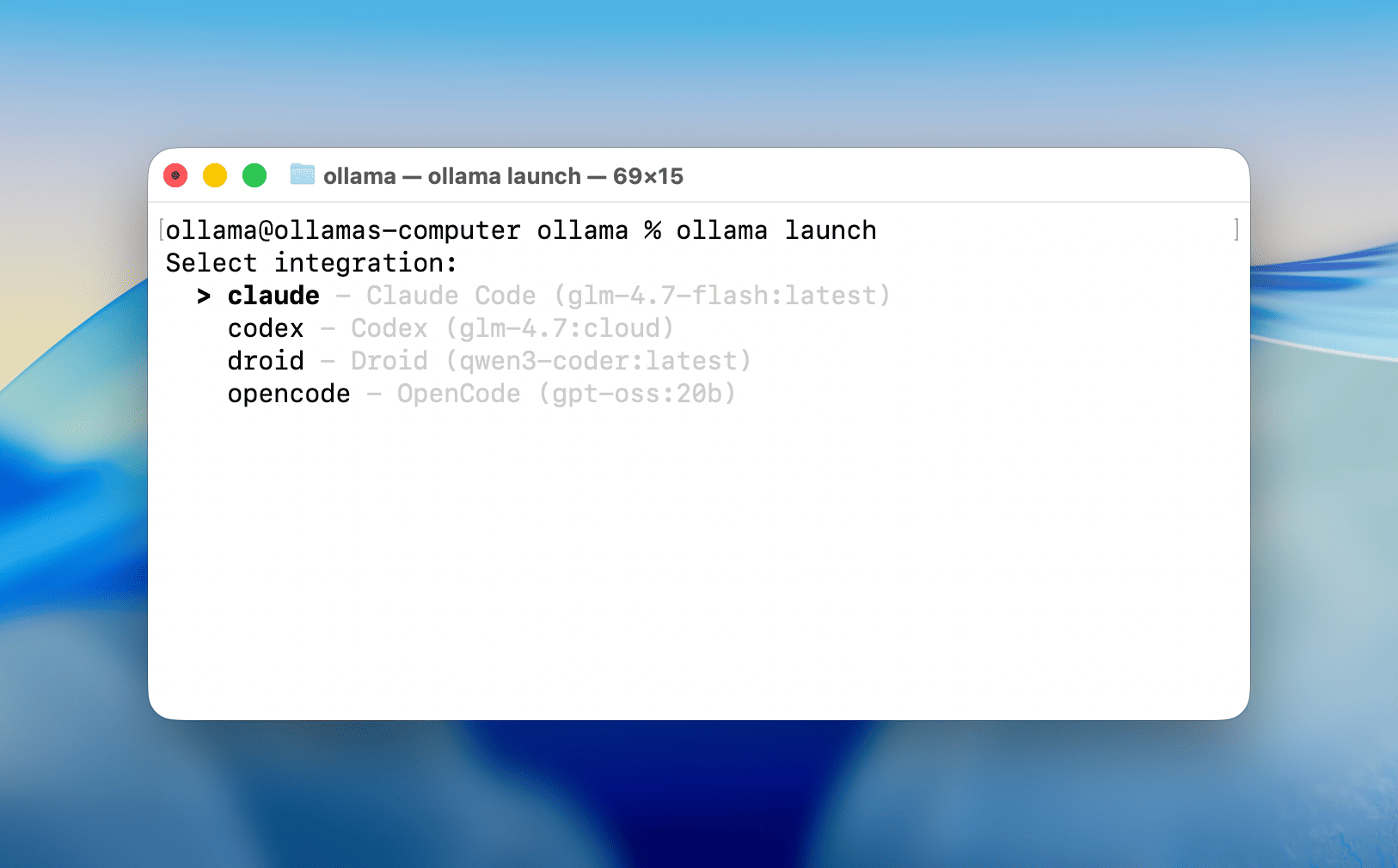

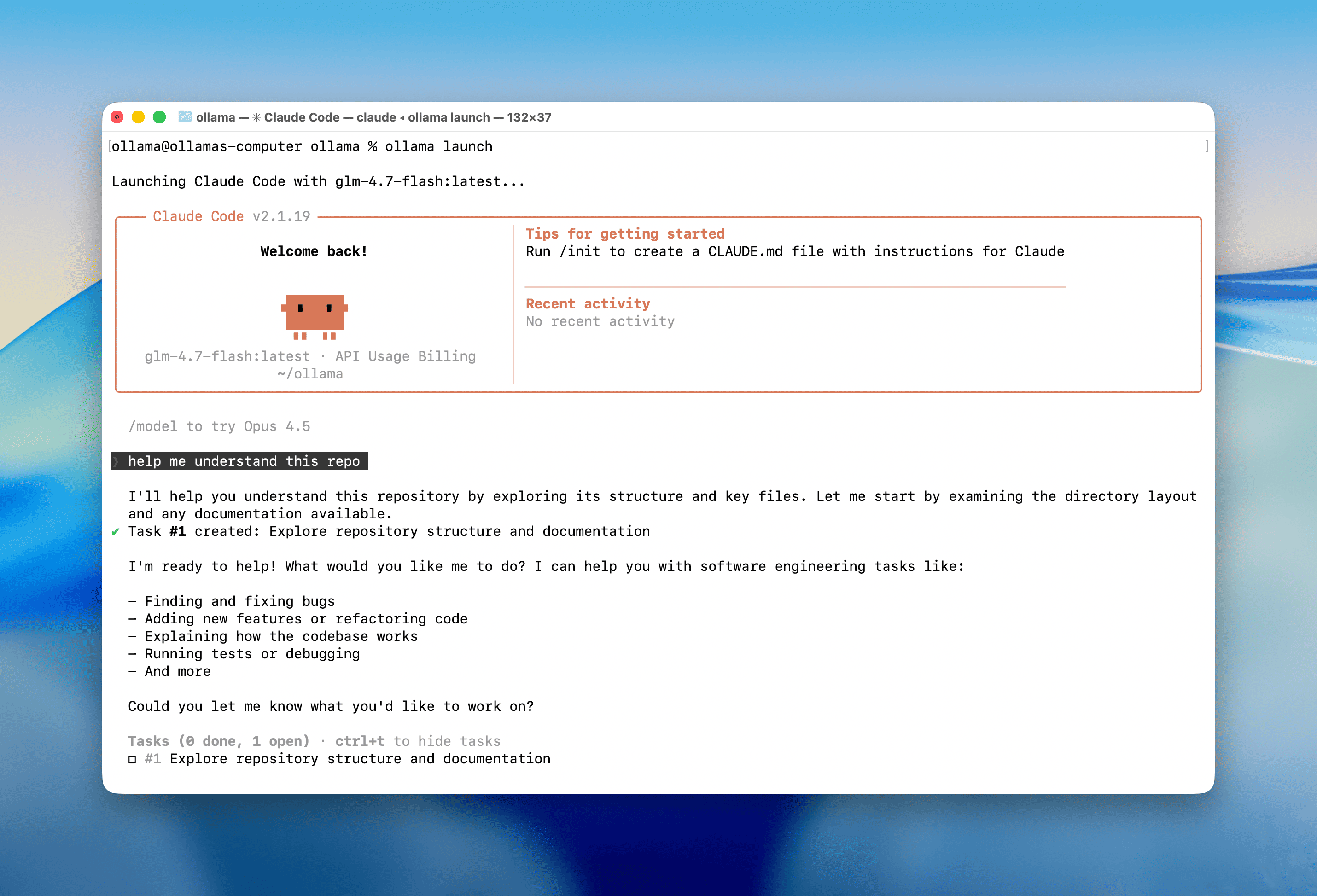

ollama launch est une nouvelle commande qui configure et exécute vos outils de codage préférés comme Claude Code, OpenCode et Codex avec des modèles locaux ou cloud. Aucune variable d’environnement ni fichier de configuration n’est nécessaire.

Téléchargez Ollama v0.15+, puis ouvrez un terminal et exécutez :

# ~23 GB VRAM required with 64000 tokens context length

ollama pull glm-4.7-flash

# or use a cloud model (with full context length)

ollama pull glm-4.7:cloud

Code Claude :

ollama launch claude

OpenCode :

ollama launch opencode

This will guide you to select models and launch your chosen integration. No environment variables or config files needed.

Note: Coding tools work best with a full context length. Update the context length in Ollama’s settings to at least 64000 tokens. See the context length documentation on how to make changes.

Local models:

glm-4.7-flashqwen3-codergpt-oss:20bCloud models:

glm-4.7:cloudminimax-m2.1:cloudgpt-oss:120b-cloudqwen3-coder:480b-cloudIf you have trouble running these models locally, Ollama also offers a cloud service with hosted models that has full context length and generous limits even at the free tier.

With this update Ollama now offers more usage and an extended 5-hour coding session window. See ollama.com/pricing for details.

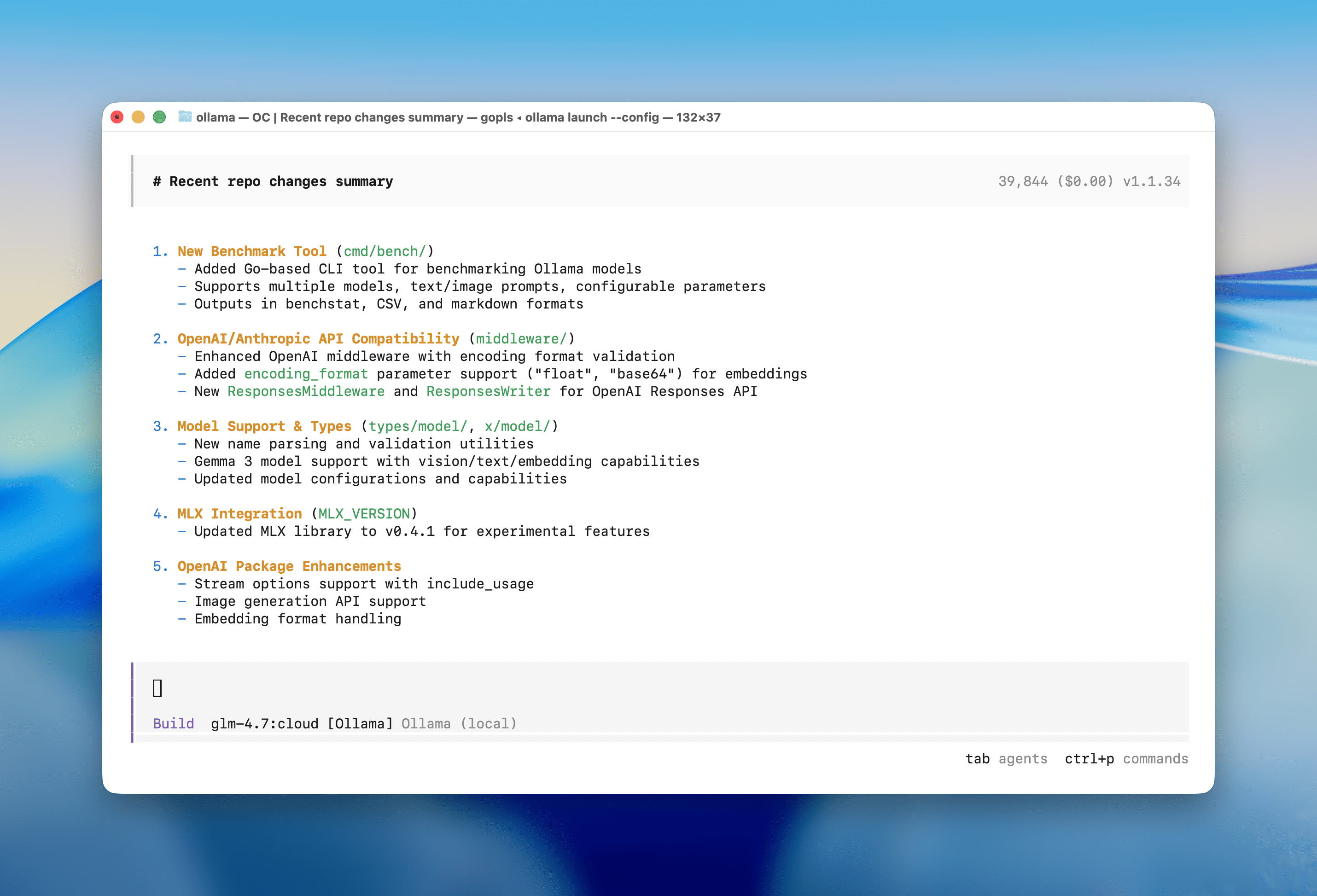

To configure a tool without launching it immediately:

ollama launch opencode --configollama/ollama: Get up and running with OpenAI GLM-4.7, DeepSeek, gpt-oss, Qwen, Gemma and other models.https://github.com/ollama/ollama/blob/main/README.mdhttps://github.com/ollama

Context length - Ollama https://docs.ollama.com/context-length

Pas possible avec PHI4

Mieux avec Mistral

Le service est :

■ We're currently experiencing high demand, which may cause temporary errors.

Dans un monde où quelques géants technologiques façonnent notre réalité numérique, la question n’est plus de savoir si nous sommes dépendants, mais comment nous en libérer. Chaque jour, des milliards d’individus, des millions d’entreprises et des milliers d’institutions publiques confient leurs données, leurs processus décisionnels et leurs infrastructures critiques à une poignée d’acteurs :

les GAFAM américains et leurs équivalents chinois (BATX).

Ce livre n’est ni un manifeste alarmiste ni une utopie technologique. C’est un guide pratique pour décrypter les mécanismes de cette « dictature invisible » et bâtir des alternatives, en s’appuyant sur l’écosystème européen.

Elle sélectionne les candidats, modère les débats, filtre l’information, influence les décisions judiciaires et sanitaires, et façonne nos comportements — le plus souvent sans transparence, sans contrôle démocratique, et selon des normes culturelles qui nous échappent.

Ce que nous nommons « dictature de l’IA »

Le terme « dictature » renvoie historiquement à un pouvoir absolu, non partagé, non contrôlé. Transposé au numérique, il désigne un régime où :

le pouvoir est concentré entre quelques plateformes ;

les règles sont opaques, non négociables ;

les comportements sont normalisés par l’architecture des choix ;

les alternatives sont impraticables, créant un lock-in systémique (une dépendance structurelle qui rend le changement coûteux, voire impossible) ;

les recours sont inexistants, les décisions algorithmiques étant souvent inattaquables.

Cette dictature n’est pas exercée par un tyran humain, mais par un système techno-économique qui gouverne :

par l’infrastructure : contrôler les serveurs, c’est contrôler l’accès à l’information ;

par les standards : imposer ses formats, c’est imposer ses méthodes ;

par les données : agréger les connaissances, c’est détenir le pouvoir prédictif ;

par l’urgence : créer une dépendance opérationnelle, c’est garantir l’acquiescement.

C’est une dictature par convenance contrainte : nous collaborons à notre propre assujettissement pour gagner en efficacité immédiate, sans mesurer le transfert de souveraineté qu’elle implique.

La colonisation numérique par les GAFAM et les géants chinois ne se limite pas à une question d’outils : elle menace notre souveraineté cognitive, économique et politique. L’IA amplifie cette dépendance de manière exponentielle.

Quand une entreprise européenne confie son infrastructure cloud à AWS, ses données à Google Drive, sa messagerie à Microsoft, son CRM à Salesforce, et désormais ses processus d’intelligence artificielle à ChatGPT ou AWS Bedrock, elle ne délègue pas seulement des services techniques : elle externalise son autonomie décisionnelle.

Les chiffres sont éloquents : les analyses géopolitiques récentes estiment entre 65 % et 80 % la probabilité de perturbations majeures des services numériques américains en Europe d’ici 2025–2028, dans un contexte de tensions commerciales et politiques croissantes. La volatilité géopolitique transforme la dépendance technologique en risque stratégique majeur.

Parallèlement, la montée en puissance des géants chinois — Baidu, Alibaba, Tencent, Huawei, ByteDance — redessine la carte mondiale de l’IA. La bataille pour le leadership se joue sur les brevets, les talents, les données, les infrastructures et les normes. Dans cette guerre des puces et des algorithmes, l’Europe risque de devenir un territoire vassalisé, dépourvu de souveraineté technologique.

une cartographie claire des risques ;

un inventaire exhaustif des alternatives européennes ;

un chemin praticable vers l’autonomie numérique.

Dirigeants d’entreprise : évaluer les dépendances, mesurer les risques, construire un PRAN (Plan de Résilience et d’Autonomie Numérique, détaillé au chapitre 6) ;

Décideurs publics : comprendre GAIA-X, le GINUM, l’AI Act, leurs forces et leurs limites ;

Responsables informatiques : guides techniques, checklists, migrations, IA locale (Ollama, Mistral) ;

Citoyens éclairés : comprendre les enjeux démocratiques, les risques de normalisation algorithmique, et les alternatives concrètes.

Ce livre se distingue par sa double approche : critique et opérationnelle. Il ne se contente pas de dénoncer : il propose des solutions, des outils, des méthodes, et des architectures reproductibles.

Diagnostic de la colonisation numérique ;

Risques géopolitiques et dépendances stratégiques ;

Panorama des alternatives européennes ;

Maîtrise technique de l’IA locale (incluant un retour d’expérience concret sur le déploiement d’une solution souveraine : Ubuntu + Ollama + Mistral ou PHI4, détaillé au chapitre 4) ;

Gouvernance collective : GAIA-X, GINUM, AI Act ;

Plan d’action opérationnel et indicateurs de souveraineté.

La gouvernance est abordée à trois niveaux :

technique (infrastructures, standards, IA locale) ;

réglementaire (cadre européen) ;

organisationnel (stratégies internes, résilience, culture numérique).

La dictature de l’IA n’est pas une fatalité. L’intelligence artificielle peut devenir un outil d’émancipation si nous la maîtrisons plutôt que de la subir. La souveraineté numérique n’est ni un fantasme nationaliste ni un repli protectionniste : c’est une condition de liberté, de sécurité et de prospérité dans un monde où le numérique est devenu le substrat de toute activité humaine.

L’objectif n’est pas de bâtir une forteresse, mais un écosystème diversifié, résilient et éthique. L’Europe possède des atouts uniques : excellence scientifique, puissance réglementaire, valeurs humanistes.

Ce livre vous donnera les clés pour agir. À vous de les utiliser.

Ce livre diagnostique la dépendance critique de l'Europe aux infrastructures numériques américaines (GAFAM + NVIDIA) et chinoises (BATX), transformant la commodité technologique en vulnérabilité stratégique. Il y est estimé qu'entre 65% et 80% la probabilité de perturbations majeures des services cloud américains en Europe d'ici 2028 pourrait être effectives, rendant urgent le développement d'alternatives souveraines et Européennes.

Le livre combine analyse géopolitique rigoureuse et guides techniques pratiques, proposant une feuille de route en six chapitres : diagnostic de la colonisation numérique, évaluation des risques géopolitiques, panorama des alternatives européennes (GAIA-X, OVHcloud, Scaleway), maîtrise technique de l'IA locale via la stack Ubuntu + Ollama + Mistral/PHI4 (SLM), gouvernance collective (GINUM, AI Act), et plan d'action opérationnel (PRAN).

Voir un retour d'expérience concret (REX) démontrant qu'une infrastructure souveraine coûte 34% moins cher qu'une solution GAFAM sur 5 ans (économie de 225k€ annuels pour une PME de 100 employés), tout en éliminant les risques géopolitiques. Le livre inclut un thriller techno géopolitique fictif ("La Grande Déconnexion") illustrant un scénario de coupure des câbles transatlantiques et perte des GPS / horloges atomiques.

Destiné aux DSI, dirigeants d'entreprise, décideurs publics et citoyens éclairés, cet ouvrage démontre que la souveraineté numérique n'est ni utopie idéologique ni repli protectionniste, mais une condition opérationnelle de liberté, de sécurité et de prospérité à l'ère de l'IA.

https://www.amazon.fr/dp/B0GGZ9ZQDC

https://www.ugaia.eu/ https://larselesrse.blogspot.com/

https://gouver2020.blogspot.com/

https://cluboffice2010.blogspot.com

Sur YouTube :

https://www.youtube.com/@EROLGIRAUDY

Mes 15 livres :

https://www.ugaia.eu/p/mes-livres.html

Dans| le Catalogue général de la BnF :

Users Group Artificial Intelligence Agentique (U.G.A.I.A.) mon blog : https://www.ugaia.eu

Mes réseaux sociaux : http://about.me/giraudyerol

L' AI pour la Généalogie de UGAIA

L’intelligence artificielle des service pour les généalogistes : https://uga-ia.blogspot.com/